一、部署前准备

- 硬件配置要求

| 资源类型 | 最低要求 | 推荐配置 | 适用场景 |

| CPU | Intel Xeon 8核/AMD EPYC | 16核以上 | 小型企业轻量级推理 |

| GPU | NVIDIA T4 (16GB显存) | A100/A800(80GB显存) | 金融高频交易、医疗影像分析 |

| 内存 | 64GB DDR4 | 128GB以上 | 大规模知识库检索 |

| 存储 | 1TB NVMe SSD | 企业级SSD阵列(RAID 10) | 消防实时视频流处理 |

注意:

- 模型参数规模决定资源需求(如DeepSeek-R1需至少4张A100 GPU并行)

- 边缘设备部署可选择NVIDIA Jetson AGX Orin(适用于消防现场终端)

deepseek 版本

| DeepSeek-V3 | 版本地址:https://github.com/deepseek-ai/DeepSeek-V3 |

| DeepSeek-R1 | 版本地址:https://github.com/deepseek-ai/DeepSeek-R1 |

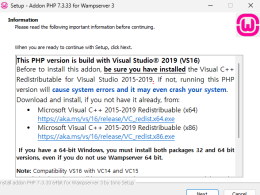

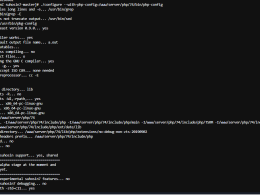

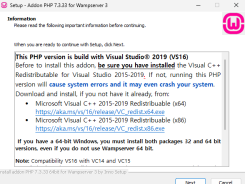

- 软件环境搭建

- 操作系统:Ubuntu 20.04 LTS/CentOS 7.9(内核≥5.4)

- 依赖库:

#bash# 基础环境sudo apt install python3.9-dev nvidia-driver-535 docker-ce

# AI框架

pip install torch==2.1.0+cu118 transformers==4.35.0 deepseek-ai-sdk容器化部署(可选):

#dockerFROM nvcr.io/nvidia/pytorch:22.12-py3RUN git clone https://github.com/deepseek-ai/deployment-tools.git二、本地部署流程

1.模型获取与准备

- 官方渠道: 通过DeepSeek企业版授权获取加密模型包(含权重文件与配置文件)

#bash

wget https://enterprise.deepseek.ai/models/deepseek-r1-v2.tar.gz

tar -xzvf deepseek-r1-v2.tar.gz -C /opt/models/2. 推理服务部署

- 快速启动API服务:

#bashdeepseek-server start \

--model-path /opt/models/deepseek-r1-v2 \--gpus 0,1,2,3 \--quantization int8 # 量化压缩选项关键参数:

--max-batch-size 32:批量推理优化--trust-remote-code:允许自定义插件(如消防地理信息处理模块)

多节点集群部署(金融级高可用):

#yaml

# kubernetes部署示例(deepseek-cluster.yaml)

apiVersion: apps/v1

kind: Deployment

spec:

replicas: 4

template:

containers:

- name: deepseek-node

image: deepseek-ai/inference:2.4.1

resources:

limits:

nvidia.com/gpu: 23.安全加固配置

- 网络隔离:

#bash

iptables -A INPUT -p tcp --dport 7860 -j DROP # 禁用公网访问

vpn-tool --create-tunnel medical-network --ip 10.8.0.0/24数据加密:

#python

from deepseek.security import ModelEncryptor

encryptor = ModelEncryptor(key="hospital-2024-key")

encryptor.protect("/opt/models/deepseek-r1-v2")三、垂直场景定制化

- 领域微调(以医疗为例)

- 数据准备:

#python

from deepseek.datasets import MedicalFineTuneDataset

dataset = MedicalFineTuneDataset(

emr_path="/data/emr/",

lab_reports="/data/lab/2024/"

)微调训练:

#bash

deepseek-train finetune \

--base-model /opt/models/deepseek-r1-v2 \--dataset medical-2024 \

--lora-r 16 # 使用LoRA降低显存占用- 知识库集成(RAG架构)

向量数据库构建:

#python

from deepseek.rag import VectorIndexBuilder

builder = VectorIndexBuilder(model="deepseek-embedding-v3")

builder.build(

docs_dir="/data/fire-safety-regulations/",

output_index="/opt/indices/fire-2024.index")检索增强推理:

#python

response = deepseek.query("如何处置化学品火灾?",

retriever={"index": "/opt/indices/fire-2024.index","top_k": 3})四、运维与监控

- 性能监控体系

- Prometheus指标采集:

#yaml

# prometheus.yml 配置片段-

job_name: 'deepseek_metrics'static_configs:- targets: ['10.8.0.11:9091', '10.8.0.12:9091']- 关键监控项:

gpu_mem_usage > 90%:触发自动扩缩容request_latency_99 > 2s:启动降级策略

- 动态量化:

#python

from deepseek.optimize import DynamicQuantizer

quantizer = DynamicQuantizer(precision="int4")

quantizer.apply(model) # 运行时自适应压缩缓存加速:

#python

deepseek-cache init --size 50GB # 高频问答缓存五、典型问题解决方案

| 问题现象 | 排查步骤 | 修复方案 |

| GPU显存OOM | nvidia-smi检查显存占用 | 启用梯度检查点(–gradient-checkpointing) |

| 响应时延突增 | 检查网络带宽(iftop)与队列深度 | 增加Batch Size或启用异步推理 |

| 生成内容不符合业务规范 | 审查微调数据质量与RLHF对齐策略 | 注入领域规则到Prompt模板 |